DeepSeek 大动作:全新推理加速技术FlashMLA引爆社区!

DeepSeek 开源大动作:全新推理加速技术引爆社区!

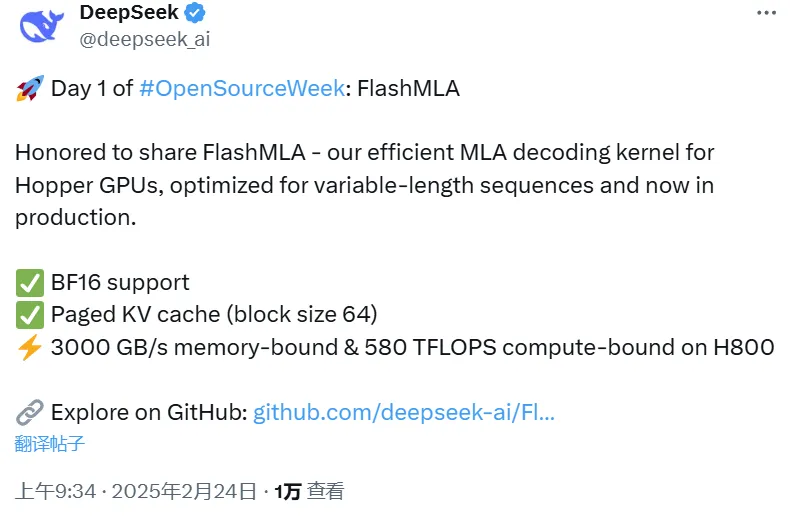

上周五,人工智能领域的明星公司 DeepSeek 在推特上宣布,本周将是他们的「开源周」(OpenSourceWeek),计划连续发布五个开源项目。消息一出,便引发了业内的广泛关注。而就在本周一,DeepSeek 用实际行动兑现了承诺,正式推出了第一个开源项目——一款专为 Hopper GPU 优化的高效 MLA 解码内核:FlashMLA。

开源 45 分钟,Star 数飙升!

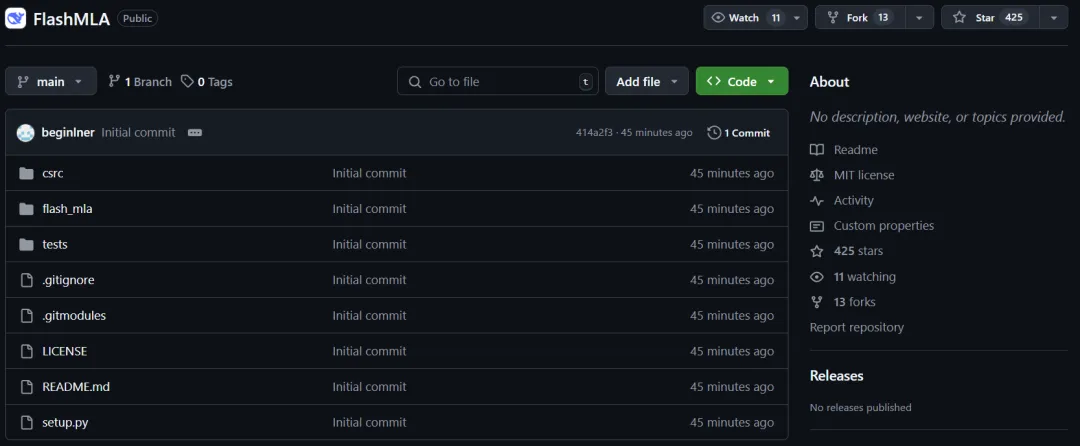

北京时间周一上午 9 点(硅谷时间周日晚间),DeepSeek 发布了 FlashMLA 的开源代码。仅仅 45 分钟,这个项目的 GitHub 页面就吸引了超过 400 个 Star!而我们截取数据时,这个数字还在持续飙升,足见社区对这一技术的高度认可。

项目地址:GitHub - DeepSeek-AI/FlashMLA

MLA 技术的核心价值

MLA(Memory-Limited Attention)是 DeepSeek 在大模型推理领域的一项重要技术创新。它的核心目标是通过减少推理过程中使用的 KV Cache(键值缓存),让模型能够在更少的硬件资源上完成更长上下文的推理任务。这一技术不仅提升了计算效率,还显著降低了推理成本。

此次,DeepSeek 直接将这一核心技术的改进版本开源,毫无保留地分享了他们的技术成果,可谓诚意十足。

FlashMLA 的技术亮点

根据官方介绍,FlashMLA 是一个为 Hopper GPU 专门优化的高效 MLA 解码内核,特别适用于可变长度序列的服务场景。它的设计目标是进一步提升推理效率,为开发者提供更强大的工具。

目前,开源内容包括以下两大亮点:

- 支持 BF16(半精度浮点数),提升计算性能。

- 支持块大小为 64 的分页 KV Cache,优化内存使用。

总结

DeepSeek 的这次开源行动,不仅展示了他们在推理加速领域的技术实力,也为开发者社区带来了极具价值的工具。随着「开源周」的继续推进,后续还将有更多项目陆续发布,值得期待!

如果你对大模型推理优化感兴趣,不妨访问项目地址 FlashMLA,体验一下这款高效解码内核的魅力吧!

超高速计算的秘密武器:H800 SXM5 GPU

在当今的高性能计算领域,H800 SXM5 GPU 凭借其惊人的速度表现脱颖而出。它的内存速度上限高达 3000 GB/s,计算能力更是达到了 580 TFLOPS,堪称计算领域的“速度之王”。

如果你想部署一个基于这款 GPU 的项目,以下是你需要准备的基础环境:

部署前的必备条件

- Hopper GPU(如 H800 SXM5)

- CUDA 12.3 或更高版本

- PyTorch 2.0 或更高版本

如何快速启动项目?

1. 安装项目依赖

只需运行以下命令,即可完成安装:

python setup.py install2. 运行基准测试

想要验证性能?运行以下命令即可:

python tests/test_flash_mla.py性能表现:突破极限的计算与内存速度

在 CUDA 12.6 环境下,H800 SXM5 在不同配置下的性能表现令人惊叹:

- 内存绑定配置:实现高达 3000 GB/s 的内存速度。

- 计算绑定配置:达到 580 TFLOPS 的计算能力。

使用示例:快速调用核心功能

以下是一个简单的代码示例,展示如何使用 flash_mla 模块的核心功能:

from flash_mla import get_mla_metadata, flash_mla_with_kvcache

# 获取元数据和分片数tile_scheduler_metadata, num_splits = get_mla_metadata( cache_seqlens, s_q * h_q // h_kv, h_kv)通过调用 get_mla_metadata,你可以轻松获取调度元数据和分片数量,用于优化计算任务的分配。

总结

H800 SXM5 GPU 的强大性能为高性能计算和 AI 模型训练提供了强有力的支持。无论是超快的内存速度还是惊人的计算能力,它都能助力开发者轻松应对复杂任务。如果你正在寻找一款能突破性能瓶颈的硬件解决方案,H800 SXM5 无疑是你的理想选择。

在这段代码中,for i in range(num_layers): 表示我们正在对某个模型的多层结构进行循环处理。每一层都会调用一个名为 flash_mla_with_kvcache 的函数,该函数的功能看起来是处理一组输入数据,包括查询向量 (q_i)、键值缓存 (kvcache_i)、块表 (block_table)、缓存序列长度 (cache_seqlens)、以及其他参数,比如 dv 和 tile_scheduler_metadata 等。这里的 causal=True 参数则表明,这个处理可能涉及因果关系的约束,比如在生成式模型中,确保后面的预测不会影响前面的输入。

项目发布后,网友热议不断

这款技术一经发布,立刻引发了广泛关注,网友们纷纷点赞,称其为技术领域的一大突破。

甚至还有人开玩笑说:「听说第五天就要实现 AGI(通用人工智能)了!」

这样的调侃也从侧面反映了大家对这项技术的期待和认可。

结语:真正的 OpenAI 风范

最后,还是那句经典的话:这才是真正的 OpenAI!